Stability AIはあの有名なStable Diffusionを世に送り出した話題のAI企業が今度は動画生成AIを世に送り出しました。 Stable Video Diffusionをブラウザから操作できるwebuiを作ってくれた方がGitに設定も載せてくれているので、早速img2videoを試しました。

目次

①今日のコンセプト

Stable Video Diffusionで画像から動画を生成する。

PCスペック

CPU:Core i7-12700 GPU:NVIDIA RTX-4070 メモリ:32.0 GB ストレージ:M.2 SSD

②インストール

Stable Video Diffusionを組み込んでwebui化してくれた方のGitと。以下を参考にさせていただきました。Windowsでの実行方法と注意点を書いてくれているのですんなり実行できました。

・SVD-webui

GitHub

GitHub – sdbds/SVD-webui

Contribute to sdbds/SVD-webui development by creating an account on GitHub.

・SVD-webuiの使い方

taziku / 生成AI開発・クリエイテ…

SVD(Stable-Video-Diffusion)をローカル環境にインストール | taziku / 生成AI開発・クリエイティブスタ…

先日、Stable Video Diffusionがリリースされ、オープンソースで気軽に、image to videoが試せるということで世界的に話題になっていますが、今回はStable-Video-Diffusion…

②-01. インストール

インストールは参考記事のまんまなので軽く流します。

git clone --recurse-submodules https://github.com/sdbds/SVD-webui/

cd SVD-webui

git submodule update --recursive --init

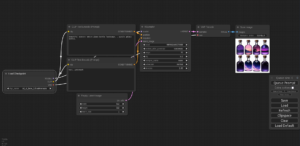

powershell -ExecutionPolicy Bypass .\install.ps1②-02. モデルデータの配置

続いてはこちらからモデルデータのダウンロードをします。 必要となるファイルはsvd.safetensorsです。 ダウンロードが終わったら以下にファイルを移動します。

SVD-webui\checkpoints②-03. 起動

以下のコマンドでGUIを起動します。

powershell -ExecutionPolicy Bypass .\run_gui.ps1③動画を生成

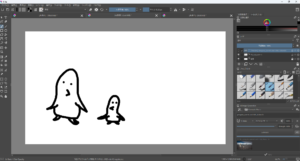

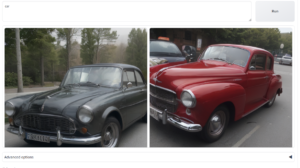

それでは動画を生成します。 生成に使用する画像は以下の2枚です。

ペンギンの画像はkritaを使って落書きから生成した画像です。また、フリー素材の猫の写真を拾って来たのでそちらも使って生成されるものを見ていきます。 ページ上部に画像をドラッグ&ドロップで配置します。

設定部分は特にいじらずに生成してみます。

生成中はPCの動作がかなり重くなりました。 RTX-4070には少し荷が重そうです。。また、初回実行時には何かをダウンロードしているようで少し時間がかかります。生成にも5分程度かかるので待ちます。 そして生成できたのが以下です。

どちらもちょっと形が怪しいですね。。 まだ何も詰めずに生成しているので精度は全然だめですが、比較的簡単に実行できたのは良かったです。

④まとめ

今回はWindows機で動画生成を行いましたがGPUの処理能力の不安が拭えなかったので普段使っているJetsonの活用ができる手法も模索して行きたいと思います。 現状ではAnimateDiffのほうが安定しているように感じますが、AI界隈は多くの方の手によってすぐに改良が進むので遠くないうちにより高品質な生成が可能になると期待しています。

⑤おまけ

こちらのSVD-webuiでは動画の生成がキレイに完了した!というふうではなく、止まってしまったふうに見えます。生成動画のプレビュー画面が真っ暗になり、再生ボタンを押しても動画は流れません。

しかし右上のダウンロードボタンを押すと生成された動画はちゃんと出てきたので生成自体はできているようです。

そのうちStable Diffusion webuiなどでできるようになるとありがたいですね。